共计 1070 个字符,预计需要花费 3 分钟才能阅读完成。

提醒:本文最后更新于 2025-08-26 16:02,文中所关联的信息可能已发生改变,请知悉!

本地部署的优势:

- 数据隐私保护:本地部署 DeepSeek 可以确保数据不会离开本地服务器,大大提高数据安全性,避免数据泄露风险。

-

灵活定制:能根据业务需求灵活调整模型参数和功能,满足特定业务场景需求。

-

离线使用:无需依赖网络,随时随地都能调用 AI 能力,尤其适合无稳定网络连接的环境。

部署过程

一、安装 Ollama

Ollama 是一个开源工具,可在本地轻松运行和部署大型语言模型。

以下为安装步骤:

常规下载安装:

- 访问 Ollama 的官方网站的下载页面

-

在下载页面选择适合你操作系统环境(Windows、Mac 或 Linux)的安装包。

完成下载后,双击安装文件,按照提示一步步完成安装过程。

简便命令安装:

对于大多数环境来说,可通过一个简单的命令完成安装:

curl -fsSL https://ollama.com/install.sh | sh

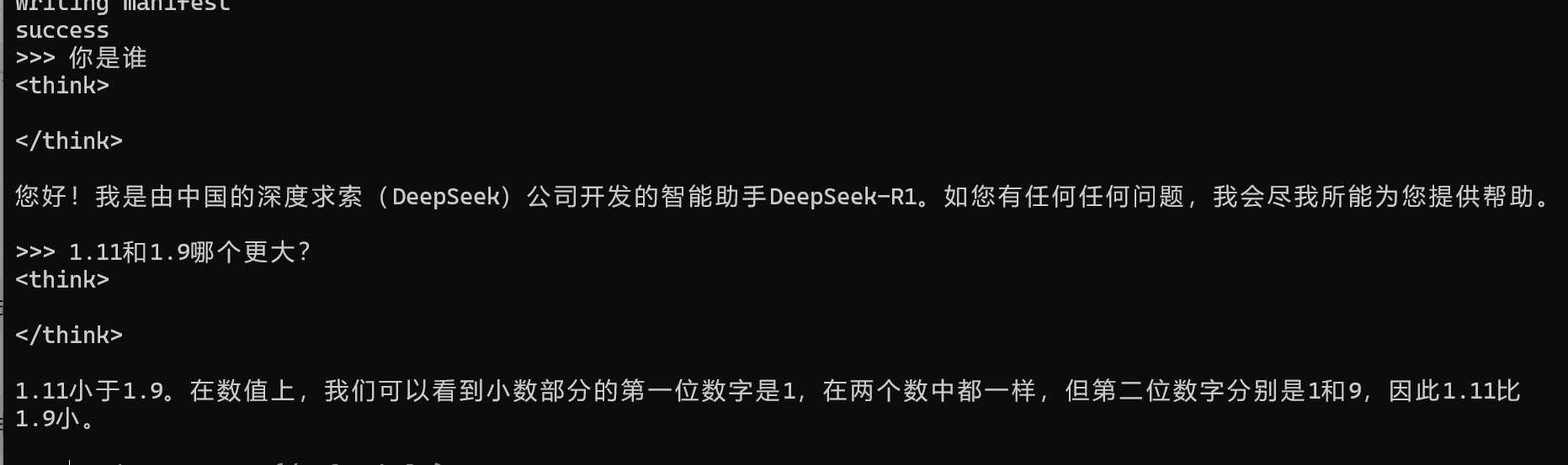

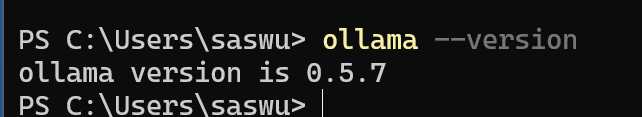

验证安装:

打开终端,输入以下命令来验证 Ollama 是否成功安装

ollama --version

出现当前安装的 Ollama 版本信息,则安装顺利完成。图示:

二、下载模型

- 模型选择

自己部署时,一般可下载 1.5B 到 70B 的模型,可对照自己的机器配置进行相关模型的下载与安装。具体信息如下:模型大小 参数量 显存需求 (GPU) CPU 和内存需求 适用场景 1.5B 15 亿 2-4 GB 8 GB 内存 低端设备,轻量推理 7B 70 亿 8-12 GB 16 GB 内存 中端设备,通用推理 8B 80 亿 10-16 GB 16-32 GB 内存 中高端设备,高性能推理 14B 140 亿 16-24 GB 32 GB 内存 高端设备,高性能推理 32B 320 亿 32-48 GB 64 GB 内存 高端设备,专业推理 70B 700 亿 64 GB+ 128 GB 内存 顶级设备,大规模推理 671B 6710 亿 多 GPU (80 GB+) 256 GB+ 内存 超大规模推理,分布式计算

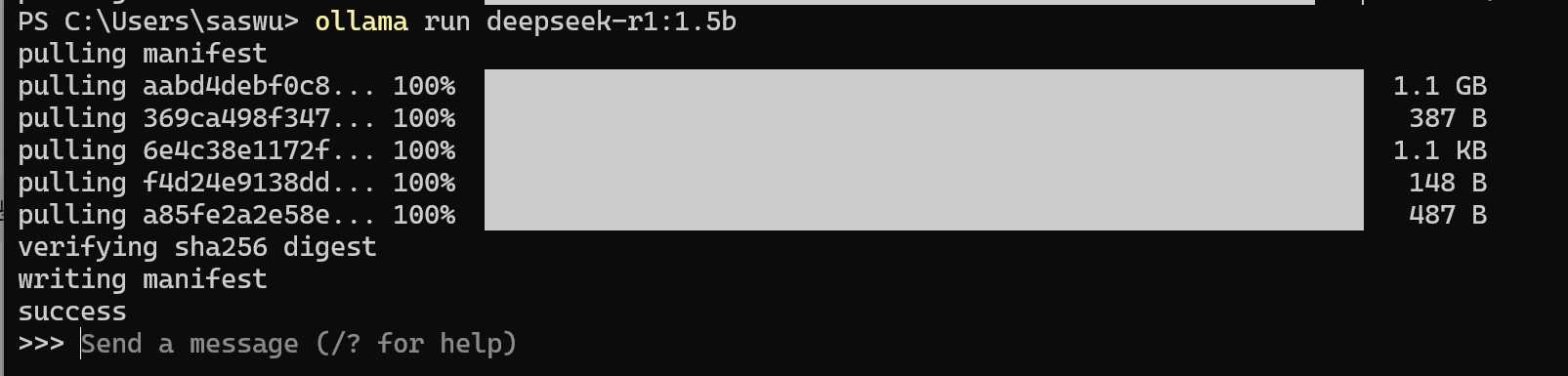

模型下载

- 在终端使用

ollmam run命令直接下载

比如要下载 1.5b 的模型,使用命令:

ollama run deepseek-r1:1.5b

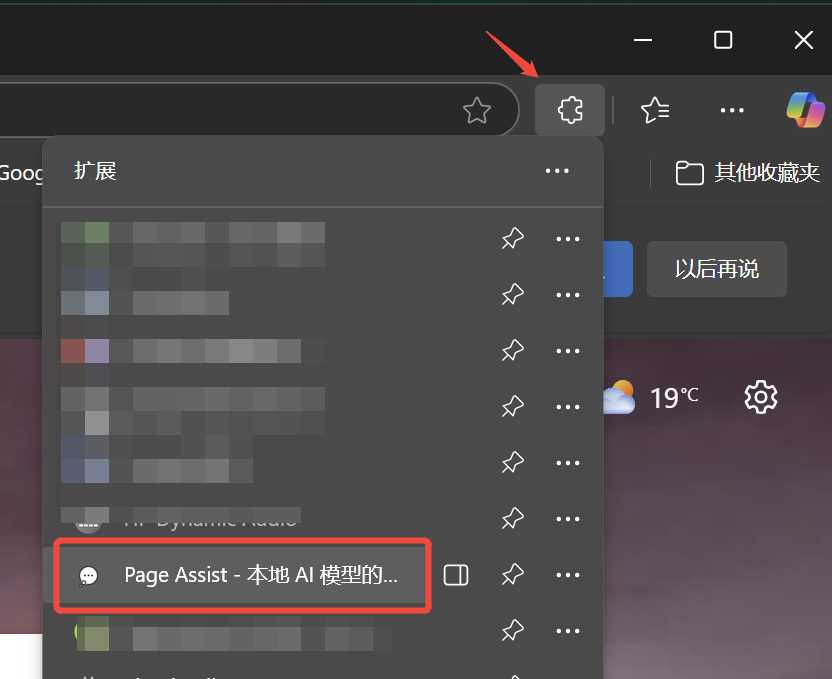

三、web ui

这里为了方便,直接使用浏览器扩展,推荐 Page Assist 这个扩展,直接搜索安装即可

快捷链接:

Edge 浏览器

Firefox 浏览器

Chrome 浏览器

扩展安装完成后点击浏览器栏的扩展图标,选择 Page Assist

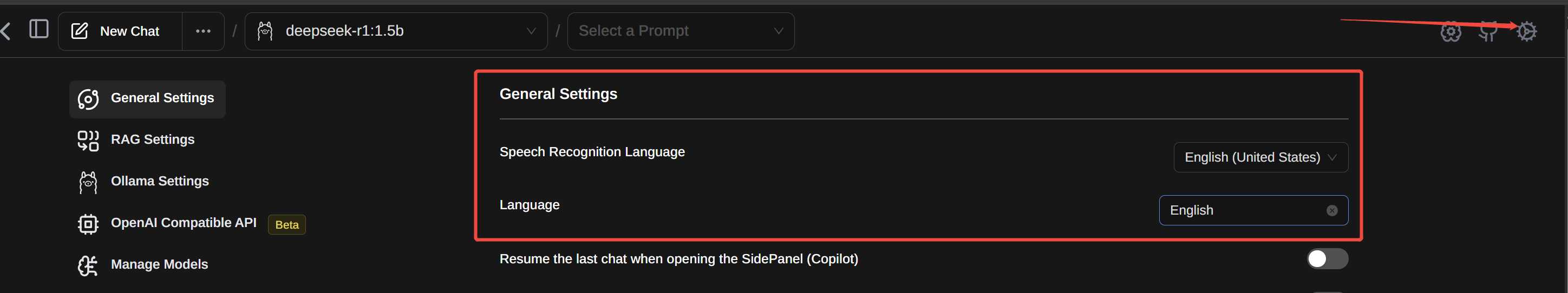

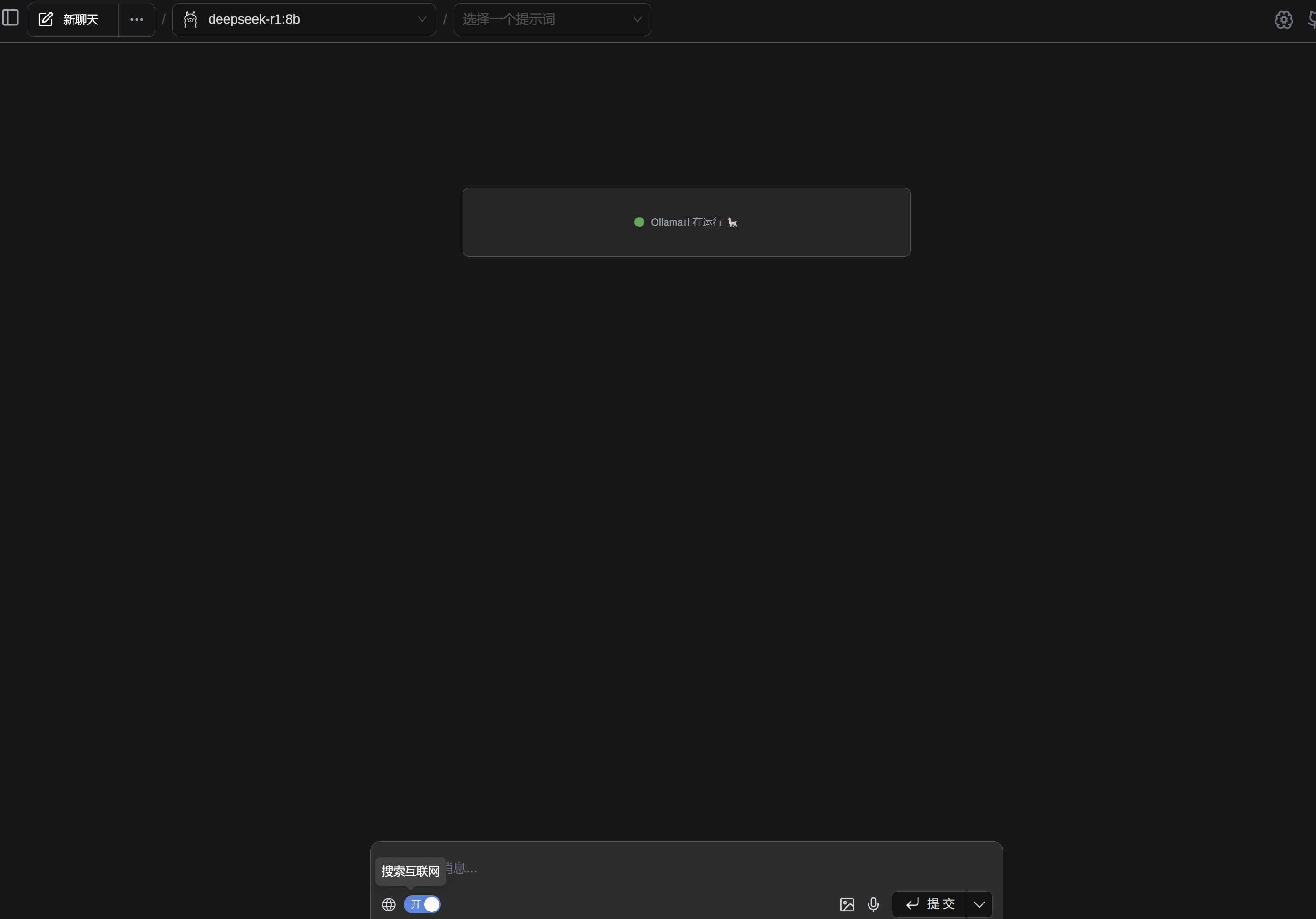

在右上角的设置里可以把页面语言改为中文

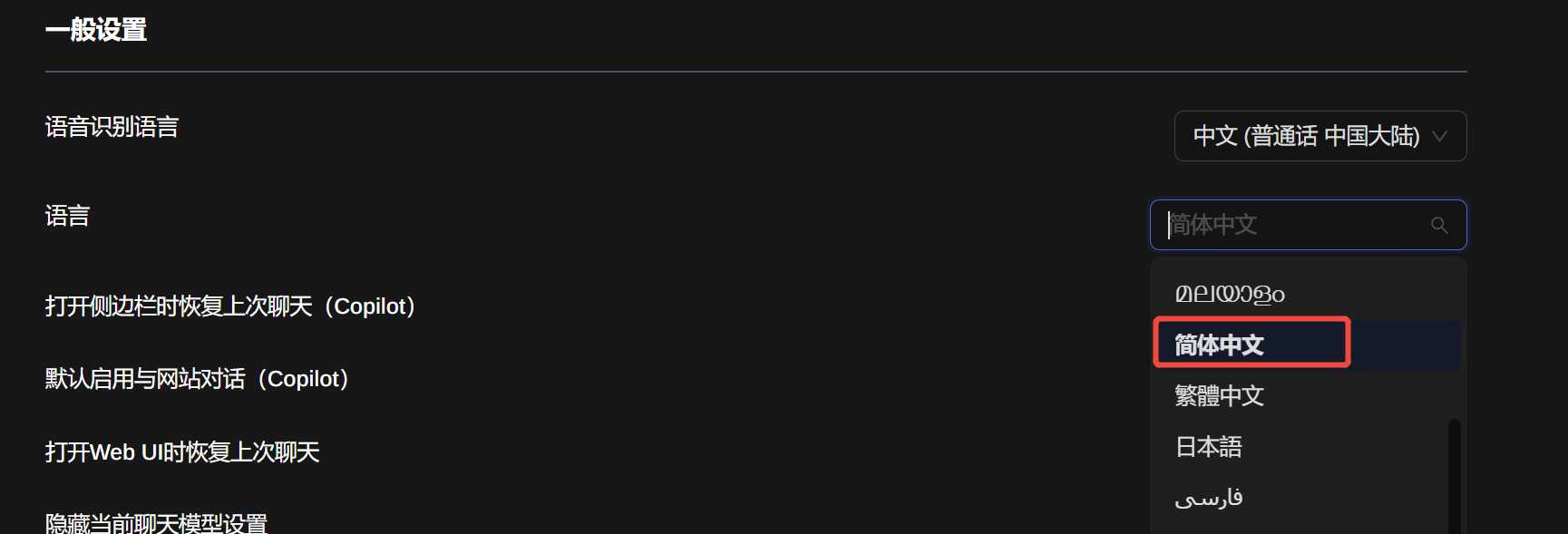

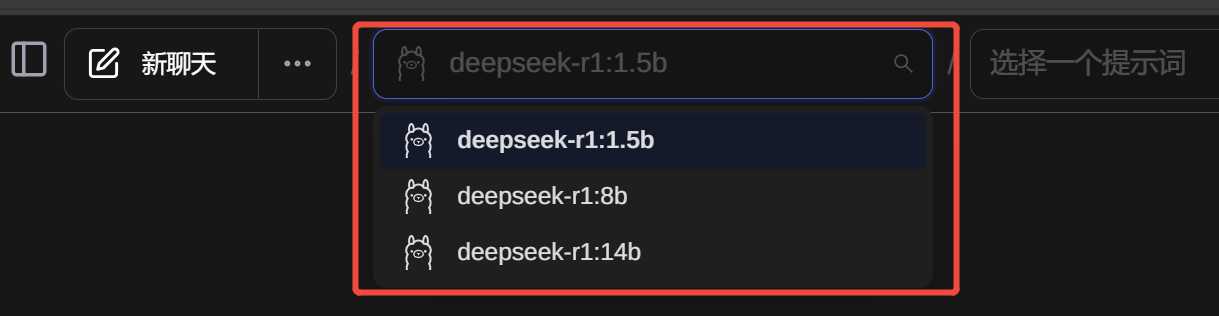

然后点击左上角的新聊天,就可以开始对话了,有下载了多个模型的,可以选择不同的模型

扩展支持网页搜索

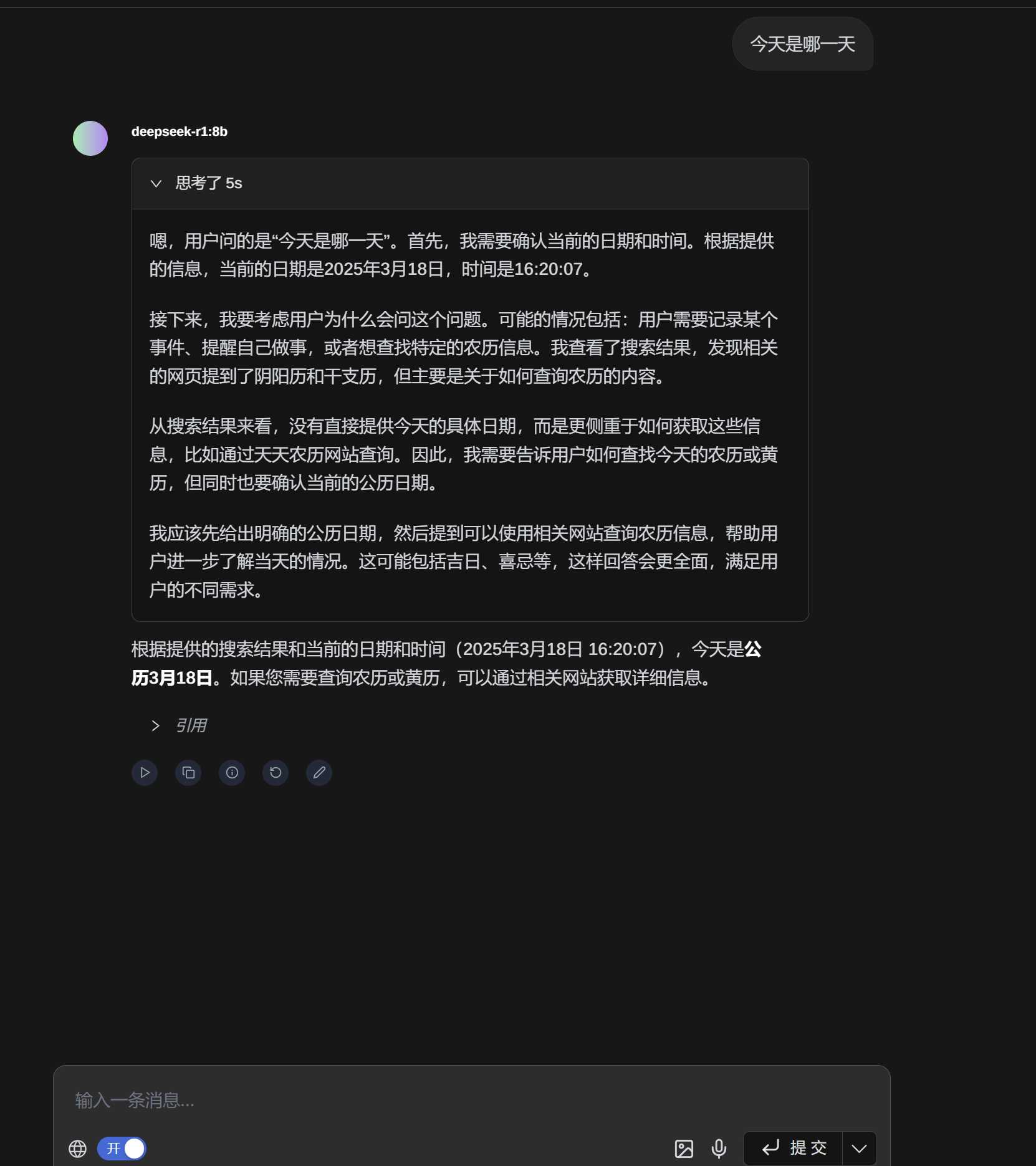

我打开网络搜索问了一下今天是哪一天(写文章这里时是 3 月 18 号)

他能正常理解是 3 月 18 号

正文完